Modèles multi-modaux en IA : définition, exemples et cas d’usage expliqués

Les modèles multimodaux changent la donne en permettant aux machines de traiter et de raisonner à partir de plusieurs types d’entrées — texte, images, audio, et même vidéo — simultanément.

Dans cet article, nous allons expliquer ce que sont les modèles multimodaux, comment ils fonctionnent, et comment les développeurs peuvent les expérimenter dès aujourd’hui grâce à l’infrastructure GPU de Nebula Block.

Qu’est-ce qu’un modèle multimodal ?

Les modèles d’IA multimodaux sont entraînés pour comprendre et combiner des informations issues de plusieurs modalités — par exemple, interpréter une image de graphique et sa légende ensemble, ou répondre à une question concernant une photo.

Contrairement aux modèles classiques à une seule modalité (ex : GPT-2), ces modèles établissent des liens entre différents formats comme le texte, la vision et l’audio pour permettre un raisonnement plus profond.

Comment fonctionnent les modèles multimodaux

Les modèles multimodaux se composent généralement de :

- Encodeurs spécifiques à chaque modalité : comme Vision Transformer (ViT) pour les images ou des transformeurs pour le texte.

- Mécanismes de fusion : attention croisée ou ponts d’attention pour combiner les signaux entre modalités.

- Espaces d’encodage communs : vecteurs unifiés représentant les concepts quelle que soit leur source.

- Génération croisée : tâches comme la légende d’image, le Q&R visuel ou le raisonnement à partir de graphiques.

Ils sont entraînés sur de vastes jeux de données appariées comme les paires image/légende (ex. COCO, LAION) ou des vidéos commentées.

Types de modèles multimodaux

| Approche | Description |

|---|---|

| Cross-Modality | Infère une modalité à partir d’une autre (ex : image → texte). |

| Fusion Models | Combine différentes entrées pour une meilleure décision. |

| Traduction de modalité | Convertit une modalité en une autre (ex : parole en texte). |

| Auto-supervisé | Apprentissage non supervisé via contraste (ex : CLIP). |

Pourquoi les modèles multimodaux sont importants

Les systèmes multimodaux sont plus adaptables et pertinents dans des contextes réels, car la communication humaine est naturellement multimodale. Ils permettent :

- Une compréhension plus riche du contexte

- Une interaction proche de celle des humains

- La recherche et le raisonnement intermodal

- L’automatisation de bout en bout dans des tâches mêlant vision, langage et données structurées

Ces modèles sont à la base des agents IA de nouvelle génération, des robots autonomes et des assistants intelligents capables de fonctionner dans des environnements dynamiques et réels.

Cas d’usage réels

| Secteur | Exemple |

|---|---|

| Santé | Diagnostiquer à partir de radios + notes médicales. |

| Commerce | Recherche de produit par image + langage naturel. |

| Finance | Combiner graphiques, actualités et rapports. |

| Support client | Comprendre captures d’écran et texte. |

| Éducation | Schémas + questions dans les applis éducatives. |

| Robotique | Navigation via vision + capteurs. |

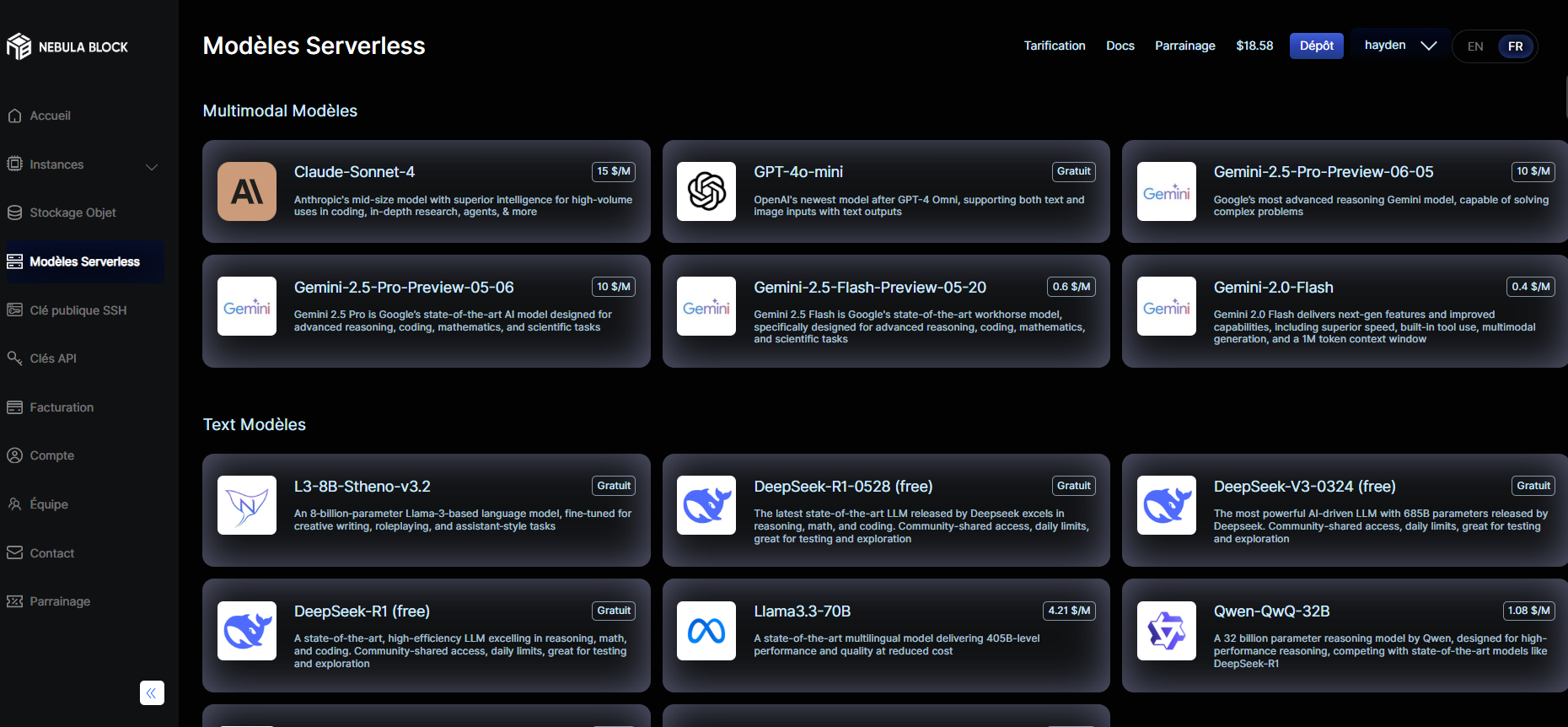

Modèles multimodaux sur Nebula Block

Vous pouvez tester dès aujourd’hui plusieurs modèles open-source multimodaux sur Nebula Block — soit dans votre propre VM GPU, soit via des endpoints sans serveur :

- Gemini-2.5-Pro-Preview : Le tout dernier modèle de Google pour le raisonnement complexe visuel + texte.

🟢 Déployable sur Nebula pour des cas d’usage haute performance. - Gemini-2.5-Flash : Variante légère optimisée pour l’inférence rapide et les tâches de codage.

🟢 Disponible dès maintenant. - API compatible GPT-4o : Prend en charge les entrées texte + image via un endpoint compatible OpenAI.

🟢 Idéal pour prototyper un chatbot sans machine dédiée.

Pourquoi exécuter ces modèles sur Nebula Block ?

Nebula Block est le premier cloud IA souverain du Canada, conçu pour la performance, le contrôle et la conformité. Il propose des instances GPU à la demande ou réservées, allant des accélérateurs de classe entreprise (NVIDIA B200, H200, H100, A100, L40S) aux options économiques comme RTX 5090, 4090, et Pro 6000 — parfait pour l’expérimentation.

Nebula Block offre un environnement flexible et convivial pour les développeurs afin d’explorer, déployer et faire évoluer des modèles multimodaux:

| Fonctionnalité | Bénéfice |

|---|---|

| Large choix de GPUs | Parfait pour l’inférence et le fine-tuning de modèles multimodaux |

| Serveurs nus & VMs | Ajustez performance et budget, mise à l’échelle facile |

| Mode sans serveur | Testez des modèles sans machine dédiée |

| Stockage compatible S3 | Gérez images, documents et embeddings facilement |

| Conteneurs préconfigurés | Lancez Gemini ou Claude en quelques secondes |

Soutenu par une infrastructure à travers le Canada et dans le monde entier, Nebula Block offre un accès à faible latence pour les utilisateurs du monde entier. Il propose également une large gamme de points de terminaison d’inférence pré-déployés — y compris DeepSeek V3 et R1 entièrement gratuits — permettant un accès instantané aux modèles de langage de pointe

✅ TL;DR

- Les modèles multimodaux combinent vision, texte, audio, etc.

- Cas d’usage : assistants IA, compréhension documentaire, chatbots, etc.

- Nebula Block prend en charge Gemini, Claude, GPT et plus encore

- VMs GPU et endpoints serverless disponibles pour tester et déployer rapidement

Conlusion

Que vous construisiez un prototype de recherche ou déployiez un assistant IA en production, les modèles multimodaux deviennent indispensables. Testez-les dès aujourd’hui avec Nebula Block et libérez tout le potentiel de l’IA multimodale !

Et ensuite ?

Inscrivez-vous et commencez à explorer maintenant.

🔍 Pour aller plus loin : consultez notre blog et notre documentation ou demandez une démo pour optimiser vos solutions.

📬 Contactez-nous : Rejoignez notre communauté Discord pour obtenir de l’aide ou contactez-nous directement.

🔗 Essayez Nebula Block maintenant

Restez connecté

💻 Website: nebulablock.com

📖 Docs: docs.nebulablock.com

🐦 Twitter: @nebulablockdata

🐙 GitHub: Nebula-Block-Data

🎮 Discord: Rejoindre la communauté

✍️ Blog: Lire notre blog

📚 Medium: Suivre sur Medium

🔗 LinkedIn: Suivre sur LinkedIn

▶️ YouTube: S’abonner sur YouTube